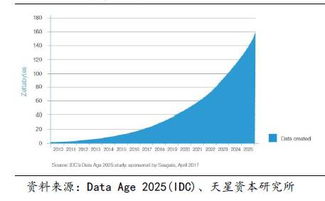

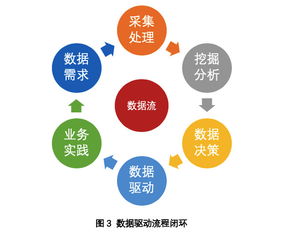

在当今数据驱动的时代,高效获取并处理网络数据已成为众多行业的核心需求。传统的静态网页爬取已无法满足动态内容加载的需求,尤其是通过Ajax技术异步加载的数据。针对这一挑战,一款被誉为“爬虫神器”的工具应运而生,它不仅能实时捕获Ajax数据,还集成了强大的数据处理和存储服务,为用户提供了一站式解决方案。

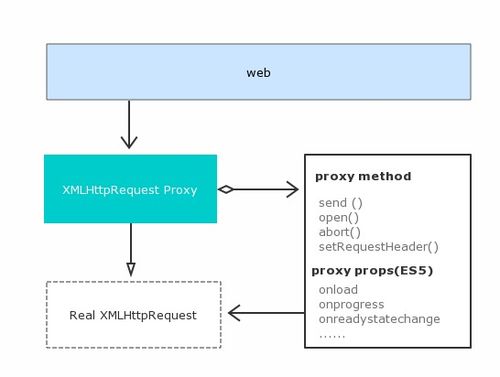

Ajax(Asynchronous JavaScript and XML)允许网页在不重新加载的情况下与服务器交换数据并更新部分内容,这虽然提升了用户体验,却给数据爬取带来了复杂性。传统爬虫往往难以抓取这些动态生成的内容,导致数据遗漏或不完整。而这款爬虫神器通过模拟浏览器行为或直接解析JavaScript,能够实时监控和拦截Ajax请求,准确提取JSON、XML等格式的数据流,确保数据的实时性和完整性。

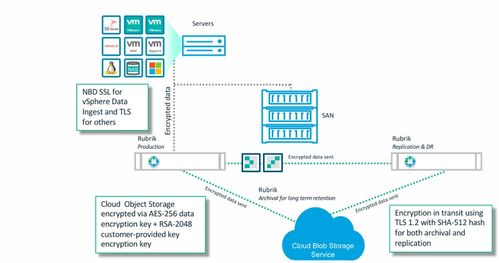

除了数据抓取,该工具的核心优势在于其内置的数据处理功能。它支持实时清洗、过滤和转换数据,例如去除重复项、格式化时间戳、提取关键字段等,用户可以通过自定义脚本或图形界面轻松配置处理规则。这大大减少了后续数据整理的负担,让原始数据即刻变为可用信息。其存储服务灵活多样,支持将处理后的数据保存到多种数据库中,如MySQL、MongoDB、Elasticsearch,或直接导出为CSV、JSON文件,甚至实时同步到云存储服务,确保数据安全且易于访问。

在实际应用中,这款爬虫神器适用于电商价格监控、社交媒体分析、新闻聚合等多个场景。例如,电商企业可以用它实时追踪竞争对手的产品价格和库存变化;研究人员可以收集社交媒体上的趋势数据进行分析。其高效性和易用性使得即使是非技术背景的用户也能快速上手,通过简单的配置实现自动化数据流水线。

这款集实时Ajax数据抓取、智能处理和便捷存储于一体的爬虫神器,正成为数据工作者的得力助手。它不仅解决了动态数据爬取的难题,还通过全流程服务提升了数据价值,助力用户在信息海洋中精准航行,驱动业务决策与创新。